Les enjeux juridiques de l’Intelligence Artificielle.

En Janvier 2017, le barreau de Lille a annoncé son intérêt pour la justice prédictive et compte bien être l’un des premiers barreaux Français à tester ce dispositif[1].

Les algorithmes et l’Intelligence Artificielle en général, soulèvent de plus en plus de questionnements juridiques à une époque où cette dernière est capable de vaincre un champion du jeu de Go[2].

Pour John McCarthy, l’Intelligence Artificielle (ou « IA ») est une « construction de programmes informatiques qui s’adonnent à des taches qui sont, pour l’instant, accomplies de façon plus satisfaisantes par des êtres humains car elles demandent des processus mentaux de haut niveau tels que l’apprentissage perceptuel, l’organisation de la mémoire et le raisonnement critique ».

Depuis le siècle dernier, l’Intelligence Artificielle nourrit les fantasmes les plus imaginatifs. Elle peut être vue comme un progrès pour l’humanité, facilitant la vie de l’homme et l’accompagnant dans son quotidien afin de l’aider à prendre des décisions ou à réaliser des tâches.

Mais l’Intelligence Artificielle nourrit aussi de grandes peurs, comme le reflète la littérature et le cinéma de science fiction. On peut citer l’exemple de H.A.L dans « 2001 L’odyssée de l’Espace » ou le robot Elvex dans la Nouvelle « Le Robot qui rêvait » d’Isaac Asimov, robot doté d’un véritable subconscient, capable de rêver et se positionnant comme l’équivalent des humains.

Malgré tout, l’Intelligence Artificielle est aujourd’hui une réalité, qui fait émerger un véritable débat dans le monde juridique.

Dans cette optique, le Parlement Européen a récemment publié une résolution contenant « des recommandations à la Commission concernant les règles de droit civil sur la robotique. »[3]

Les questions susceptibles d’être soulevées à propos de l’Intelligence Artificielle et la robotique concernent la transparence, la propriété intellectuelle, le régime de la responsabilité ou encore la protection des données personnelles.

La transparence nécessaire

Pour que les individus placent leur confiance dans une Intelligence Artificielle, il est nécessaire d’instaurer une totale transparence et une loyauté dans le traitement algorithmique qui l’anime.

Dans cette logique de transparence, Elon Musk, CEO de Tesla et SpaceX, a lancé des recherches sur l’Intelligence Artificielle, dont les résultats sont consultables à tout moment et mises à jour régulièrement.[4]

Dans le droit positif, des avancées ont été faites en faveur de la transparence.

On peut citer, à titre d’exemple, la loi pour une République Numérique[5] qui impose à l’Administration d’être totalement transparente lorsqu’elle exécute des traitements algorithmiques.

La nouvelle législation européenne (GDPR) en matière de protection des données personnelles imposera à l’avenir une transparence si le traitement aboutit à un profilage des individus[6].

Le texte prévoit, en effet, que le responsable d’un traitement devra informer la personne concernée « de l’existence d’une prise de décision automatisée, y compris de profilage ».

Une fois la personne informée, elle sera en mesure d’exercer, ou non, son droit d’opposition.

Cette obligation d’information doit permettre aux personnes concernées de comprendre le fonctionnement d’une IA et de montrer que celle-ci est respectueuse des principes de protection de la vie privée des individus.

D’autres principes du règlement GDPR vont impacter le développement de l’Intelligence Artificielle.

Tous les programmes développés vont devoir se plier aux exigences de la « Privacy By Design », c’est à dire qu’ils vont devoir intégrer la protection des données dés la conception.

La future Intelligence Artificielle devra aussi appliquer le nouveau principe de minimisation dans la collecte de données personnelles.

Malgré tout, cet appel à la transparence va à contre-courant de la tendance actuelle des entreprises.

Développer et mettre en œuvre une Intelligence Artificielle peut être protégé par le secret professionnel / secret de fabrique et une entreprise peut se montrer réticente à l’idée de dévoiler « sa recette » de l’Intelligence Artificielle avec le risque de voir ses concurrents proposer une meilleure solution.

Le régime de responsabilité

La question est ici de savoir quel fondement juridique appliquer si un litige survient à cause d’une Intelligence Artificielle.

La responsabilité civile de l’article 1240 du Code Civil (anciennement 1382) s’applique lorsqu’une personne commet une faute qui cause un dommage à une autre personne. L’idée qui sous-tend la responsabilité civile c’est que chaque individu doit répondre de ses actes.

L’autre principe fondateur du Code civil réside dans le fait que chaque individu qui s’oblige, engage ses biens présents et à venir (article 2284 du Code Civil).

Ainsi, l’auteur d’une faute, condamné à réparer le dommage, utilisera les biens de son patrimoine (argent) pour exécuter son obligation.

L’Intelligence Artificielle n’ayant pas la personnalité juridique, elle ne dispose pas non plus d’un patrimoine au sens du droit français. Il semble donc difficile d’appliquer le régime général de la responsabilité civile de l’article 1240 du Code Civil (anciennement 1382) à l’IA car elle ne sera pas en mesure de réparer le préjudice.

Il convient donc de regarder vers le régime de responsabilité du fait des choses.

Le gardien d’une chose (son propriétaire) peut voir sa responsabilité engagée si la chose qui est sous sa garde crée un dommage à autrui. Le gardien peut toutefois s’exonérer s’il arrive à prouver qu’aucune faute n’a été commise.

À titre d’exemple, si un robot cause un dommage à autrui, comme une blessure, c’est la responsabilité de son propriétaire qui sera engagée et qui, le cas échéant, indemnisera la victime.

La responsabilité du fait des produits défectueux de l’article 1245 du Code Civil (anciennement 1386-1) pourrait aussi s’appliquer dans ce cas de figure.

La responsabilité d’un fabricant peut être engagée si le produit qu’il a fabriqué cause un dommage à un individu car il est défectueux. Appliqué à l’Intelligence Artificielle, ces règles pourraient conduire à imaginer qu’un robot cause un dommage à autrui en raison d’un défaut de fabrication ou d’une anomalie dans le logiciel le faisant fonctionner.

Dans ce cas précis, la responsabilité du fabricant ou du développeur du logiciel pourra être engagée et il sera tenu de réparer le dommage.

Il n’y a, de notre point de vue, pas urgence à consacrer un régime de responsabilité propre à l’IA, la pratique étant susceptible d’adapter ces responsabilités historiques à l’Intelligence Artificielle. Cependant, des difficultés peuvent surgir : peut-on réellement engager la responsabilité du développeur si le dommage vient du résultat d’un calcul effectué par un algorithme ?

Dans ses recommandations pour la création d’un droit civil des robots, le Parlement Européen propose plusieurs solutions au titre de la responsabilité de l’Intelligence Artificielle.

On retrouve :

- La mise en place d’une assurance obligatoire ;

- La création d’un fonds de compensation afin d’indemniser les accidents provoqués par une Intelligence Artificielle (comme l’ONIAM pour les accidents médicaux) ;

- La création d’un numéro d’immatriculation pour faciliter l’identification des robots en leur attribuant un numéro propre ;

- La consécration d’une personnalité juridique propre aux robots afin de créer des règles spéciales pour la mise en œuvre de leur responsabilité.

L’Intelligence Artificielle est avant tout un logiciel, protégé par le droit d’auteur à condition qu’il soit original.

Ce critère d’originalité n’est pas défini dans le Code de la propriété intellectuelle.

À travers une œuvre, l’auteur exprime, sa personnalité. L’œuvre porte l’empreinte de la personnalité de son auteur. L’originalité d’une œuvre émane donc de la personnalité de son auteur.

C’est différent pour un logiciel car l’originalité s’apprécie en fonction des choix opérés par son développeur. Selon la jurisprudence, « l’organigramme, la composition du logiciel, et les instructions rédigées, quelle qu’en soit la forme de fixation constituent la forme d’expression du logiciel »[7]

D’autres titres de propriété industrielle peuvent venir renforcer la protection de l’IA, on peut notamment déposer un brevet sur les éléments techniques utilisés par le logiciel, enregistrer une marque (déposer comme marque le nom d’un robot) ou protéger les plans de conception du robot en les enregistrant auprès de l’INPI comme dessins et modèles.

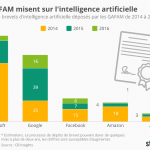

Sur l’année 2016, Microsoft a déposé 103 brevets concernant l’Intelligence Artificielle.

L’Intelligence Artificielle peut aussi aider une personne humaine à créer une œuvre de l’esprit.

La jurisprudence a déjà eu l’occasion de se prononcer sur la création d’une œuvre, assistée par ordinateur. Selon elle, l’œuvre « peut être protégée par le droit d’auteur à condition qu’apparaisse l’originalité voulue par le concepteur »[8]

C’est donc l’Homme derrière l’ordinateur qui serait titulaire des droits d’auteur. Cette jurisprudence peut être appliquée sans difficultés si l’œuvre a été crée avec l’assistance d’une Intelligence Artificielle car l’œuvre créée reflète la personnalité de l’Homme.

À l’inverse, l’IA peut être amenée à créer, elle-même, une œuvre originale.

Dans ce contexte, il est difficile de lui accorder des droits d’auteur car il faudra faire ressortir de cette œuvre le critère d’originalité. Or, il apparaît hasardeux de reconnaître à une IA qu’elle exprime sa personnalité dans une œuvre de l’esprit.

Il y a donc un lien entre Humanité et création originale. Le droit d’auteur est subjectif et n’est pas adapté pour les créations réalisées par une Intelligence Artificielle.

Afin qu’une telle protection puisse être accordée, il faudrait bouleverser le paradigme de la propriété littéraire et artistique et en faire un droit objectif, s’appliquant à n’importe quelle création, sans condition d’originalité, telle qu’elle est entendue aujourd’hui par les juridictions françaises.

[1]http://www.lavoixdunord.fr/106005/article/2017-01-20/pionniers-en-europe-les-avocats-lillois-testent-la-justice-predictive

[2] http://www.futura-sciences.com/tech/actualites/technologie-alphago-apres-avoir-battu-n-1-mondial-jeu-go-ia-prend-retraite-61409/

[3] http://www.europarl.europa.eu/sides/getDoc.do?pubRef=-//EP//NONSGML+TA+P8-TA-2017-0051+0+DOC+PDF+V0//FR

[4] Https://openai.com/about/

[5]https://www.legifrance.gouv.fr/affichLoiPubliee.do?idDocument=JORFDOLE000031589829&type=general&legislature=14

[6] Article 22 du GDPR

[7] Ccass. Ass. Plèn, 7 mars 1986, Pachot, n° 83-10.477

[8] Cour d’appel de Paris, 3 mai 2006, RG 05/03736